近年来,以深度学习为代表的人工智能技术正日益崛起,在众多领域得到广泛应用。随着数据规模的爆炸式增长,深度学习对计算和存储资源的需求急剧增大。现有的计算体系通过扩充 GPU/CPU 服务器数量,实现计算与存储能力线性增长,已经无法满足深度学习的需求,严重制约了计算机大数据知识挖掘与智能决策水平的提升。因此,亟需研究新型超高效率的计算架构,以适应数据规模海量化及信息处理智能化的新形势与新需求。

量子模拟具有经典计算欠缺的超并行计算能力,利用量子系统的叠加性和量子纠缠,对人工智能算法进行量子加速,能够极大幅度提高计算与存储性能。理论研究表明,当操控量子比特数达到 30 个左右时,量子模拟器的运算能力便能超越当前的计算机。然而,受限于现有的材料和技术,实验上能够成功精确操控的量子比特数通常为 5个左右, 远不能满足实际任务的运算需求。

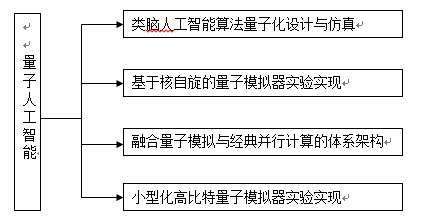

量子模拟与高性能并行计算的融合,是突破量子模拟器运算能力瓶颈的有效途径。本实验室探索量子模拟与并行计算融合的理论与计算模型,研究新型多量子比特模拟器原理及器件,设计量子模拟并行体系架构,充分发挥量子模拟单元的高速运算能力以及并行计算架构的高效数据调度与通信能力,研制多量子比特高速并行的量子人工智能机,并进一步研制基于新型材料的小型化高比特量子人工智能机。量子人工智能机的成功研制将带来运算与存储能力的大幅跃升,极大增强深度学习等人工智能技术的大数据处理能力,提高知识挖掘的全面性、准确性与及时性,提升计算机智能分析与决策水平,有望推动众多应用领域的智能化进程,该方向的具体技术内容如下图所示。